Junio '25 | ¿La calma antes de la tormenta?

Te cuento todo lo que ha ocurrido en junio de 2025 en el mundo de los LLMs.

Diría que ha sido el mes más tranquilo en cuánto a noticias de todo lo que llevamos de año. Y sinceramente, se agradece un poco de respiro… Pero eso no significa que no hayan pasado cosas interesantes, en el mundo de la IA siempre pasan cosas!

Nota: Es más que bienvenido cualquier feedback que me quieras dar sobre el formato de esta newsletter, si tienes cualquier idea o sugerencia puedes comentármela escribiéndome a juan@productomania.io

🍾 OpenAI lanza o3-pro

OpenAI anunció en diciembre del año pasado el modelo o3, aunque no lo lanzaron al público hasta abril. Lo que han hecho este mes es lanzar su versión “pro”, una versión de o3 que dedica más tiempo/esfuerzo a “razonar” y por tanto ofrece (en teoría) mejores resultados.

Está disponible para los usuarios PRO de ChatGPT (200$/mes) y también a través de la API.

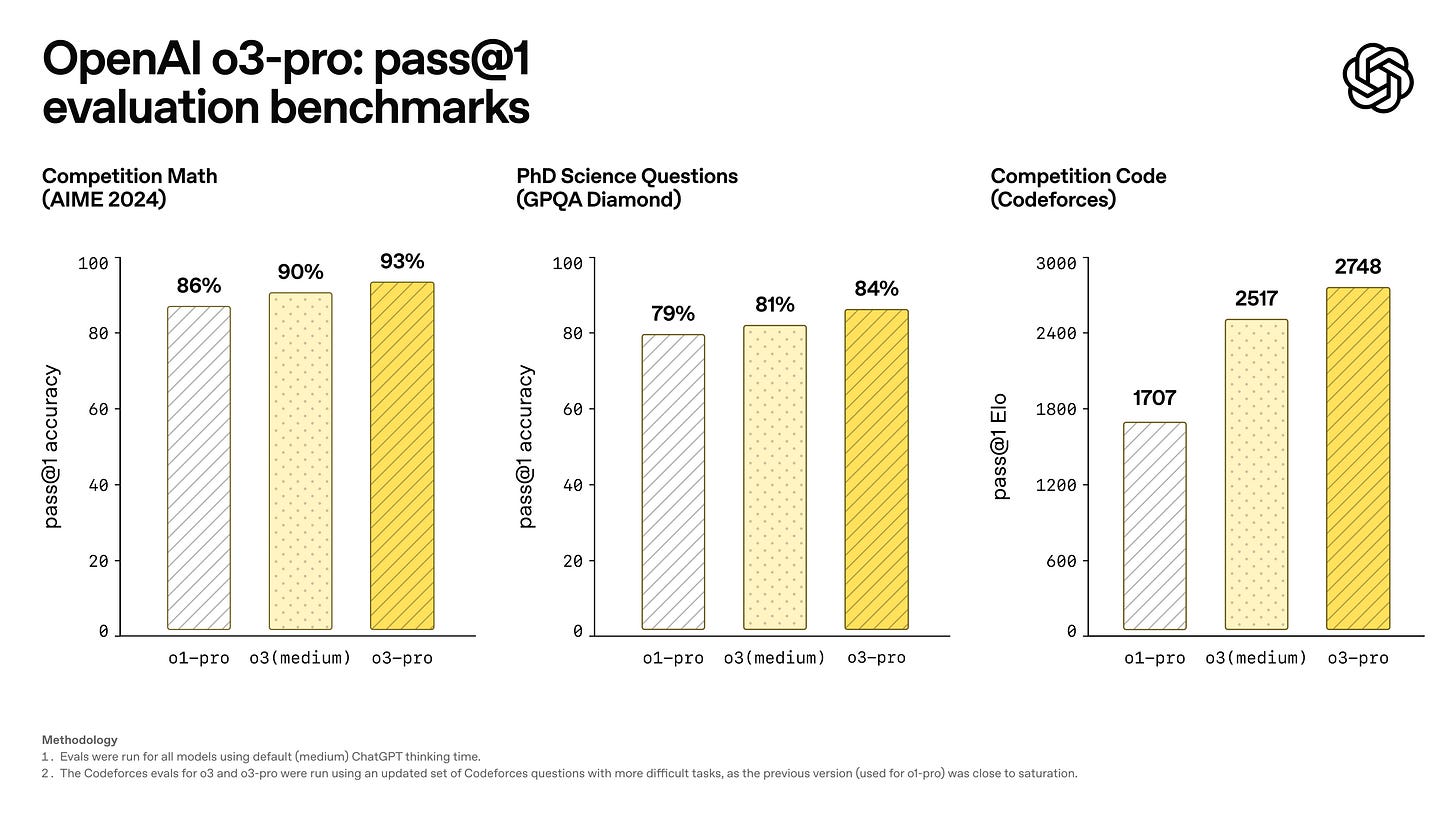

Si nos fijamos en los benchmarks que ha compartido OpenAI se puede ver que esta versión es algo mejor que la estándar, pero probablemente no tanto cómo muchos esperábamos....

Y es que OpenAI nos ha engañado un poco con el o3... El anuncio que hicieron en diciembre causó mucho revuelo porque según los resultados que compartieron el modelo fue capaz de alcanzar un 88% en el benchmark ARC-AGI. Pero ni o3 ni o3-pro se acercan a esa cifra, ninguno de los 2 es capaz de superar el 60%.

Entonces, mi pregunta es: ¿qué ha pasado con ese modelo que según OpenAI era capaz de alcanzar un 88% en el ARC-AGI? ¿Nunca ha existido o se están guardando un as debajo de la manga?

A nivel práctico o3-pro no es un modelo demasiado interesante, la diferencia con o3 no es tan grande sobre el papel y el precio es x10 veces mayor. Porque otra noticia que nos ha traído este mes OpenAI es ¡una reducción del 80% en el precio de o3! 🥳

Se mantiene la tendencia que comentábamos en la newsletter de abril, el precio de la inteligencia sigue cayendo un 90% cada año.

🔗 Enlaces de interés

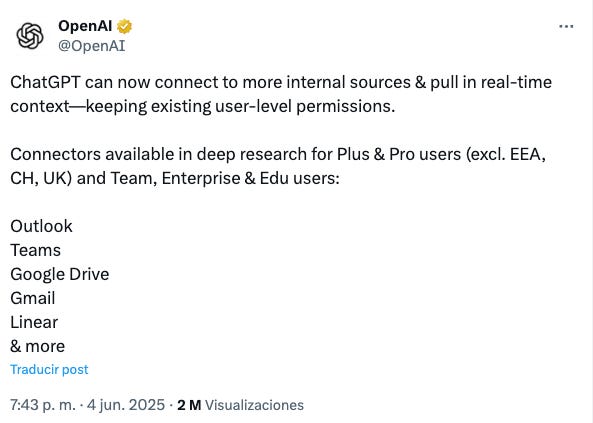

🛬 Los servidores MCP empiezan a llegar a ChatGPT

El mes pasado comentábamos que todos los grandes laboratorios de IA estaban apostando por el protocolo MCP. OpenAI introdujo la posibilidad de conectar servidores MCP en la nueva Responses API y comentamos que era cuestión de tiempo que permitieran conectar servidores MCP también en ChatGPT.

¡Pues desde hace unas semanas ya es posible! Pero de forma bastante limitada…

Han lanzado una nueva funcionalidad llamada “Conectores” que permite conectar a ChatGPT aplicaciones externas para que el agente DeepResearch pueda tirar de ellas. Existe un listado de aplicaciones populares que puedes conectar en un par de clics y ofrecen también la opción de conectar cualquier servidor MCP.

Pero el servidor MCP tiene que ser compatible con la especificación que marca ChatGPT y solo puede ser utilizado para obtener información/contexto, no para realizar acciones.

Además, de momento no está disponible en Europa… 🫠

¿Por qué han limitado tanto esta funcionalidad? ¿Por qué no permiten conectar cualquier servidor MCP directamente a ChatGPT? Pues no creo que sea por una cuestión técnica, yo creo que es más bien una decisión estratégica. Quizás quieren esperarse al lanzamiento de GPT-5, que parece estar a la vuelta de la esquina.

🔗 Enlaces de interés

🍏 Apple intenta justificar su inacción

Mientras todas las empresas tecnológicas del mundo tienen el foco puesto en desarrollar modelos y agentes de Inteligencia Artificial, Apple ha preferido dedicar sus recursos a otras tecnologías como la realidad aumentada.

Pero así cómo Google pronto se dio cuenta de que estaba perdiendo la carrera de la IA y se puso las pilas, en Apple no parecen estar preocupados. Tanto es así que lo más destacado que han hecho en lo que va de año es sacar un paper en el que intentan demostrar que los modelos razonadores realmente no razonan.

El paper es interesante y no voy a quitarles yo la razón a los investigadores de Apple, pero no creo que el departamento de marketing y comunicación esté muy contento con su publicación.

La sensación que da desde fuera es que intentan justificar su inacción tratando de argumentar que los esfuerzos que están realizando los grandes laboratorios de IA (OpenAI, Google, Anthropic, etc.) son una pérdida de tiempo. El tiempo dirá!

Te recomiendo ver el resumen+análisis que hace @dotcsv sobre el paper:

🔗 Enlaces de interés

🤖 Gemini lanza también su CLI

“Una CLI (Command Line Interface, o Interfaz de Línea de Comandos) es un modo de interacción con un sistema informático en el que tú te comunicas a través de órdenes escritas en una consola o terminal, en lugar de hacerlo mediante botones, ventanas o menús gráficos (GUI).” - dixit ChatGPT.

No lo llegué a comentar en la newsletter, pero Anthropic lanzó en febrero Claude Code, una CLI que te permite interactuar con Claude a través de la terminal. Es un producto dirigido a desarrolladores y pretende competir contra productos como Cursor, Windsurf o Github Copilot.

En abril hizo lo mismo OpenAI lanzando Codex CLI, y este mes ha sido el turno de Google con Gemini CLI.

Yo no he probado ninguno de los tres, y eso que encajo perfectamente en el target al que se dirigen estos productos. Utilizo Cursor y hasta que no vi hace unos días este vídeo no entendía por qué iba alguien a preferir utilizar una CLI a utilizar un IDE como Cursor o VSCode + Github Copilot.

Anthropic, OpenAI y Gemini no han creado CLIs, lo que han hecho realmente es crear sus propios agentes programadores. La CLI es simplemente la interfaz, podrían haber creado su propio IDE e integrado el agente dentro de él, pero han preferido crear un CLI.

En el vídeo lo explican muy bien, la ventaja que tienen los laboratorios de IA a la hora de crear agentes programadores es que al controlan tanto el modelo como las herramientas del agente, por lo que pueden entrenar a sus modelos para que aprendan a utilizar mejor esas herramientas.

Empresas como Cursor, en cambio, solo controlan las herramientas, porque no tienen modelos propios. Esto actualmente es una ventaja para el usuario, una de las cosas que más me gusta de Cursor es la libertad que tengo para decidir qué modelo quiero utilizar en cada momento. Pero a largo plazo puede ser claramente una barrera para mejorar el rendimiento del agente.

Es un tema muy interesante, porque cuestiona la viabilidad (y valoración) de las cientos o miles de empresas que están surgiendo en el sector del “vibe-coding”.

🔗 Enlaces de interés

🕵🏻♂️ DeepResearch de OpenAI disponible a través de la API

Han pasado ya 4 meses desde que OpenAI lanzara DeepResearch. Si todavía no lo has probado te recomiendo hacerlo, lo tienes disponible en ChatGPT y funciona muy bien para realizar investigaciones o búsquedas complejas que requieren de consultar muchas fuentes.

La buena noticia es que este agente está ahora disponible a través de la API, lo que permite integrarlo de una forma sencilla dentro de cualquier workflow o aplicación.

Yo no tenía nada claro que OpenAI fuera a añadir este agente a la API. Históricamente siempre han ido añadiendo a sus APIs todos los nuevos modelos y funcionalidades que han ido añadiendo a ChatGPT, pero no confiaba en que fueran a continuar con esta estrategia.

La buena noticia es que siguen apostando por esta estrategia, lo que nos permite a los que construir software integrar su tecnología en nuestros productos.

La mala noticia es que este agente es tremendamente caro.

Tiene el mismo precio que tenía o3 antes de la reducción del 80% que comentaba antes, por lo que es 5 veces más caro que el o3 actual. Pero lo peor es la cantidad de tokens que gasta, he hecho una prueba a través del playground para pedirle que me hiciera un resumen de las noticias de junio relacionadas con el mundo de los LLMs y ha consumido 1M de tokens.

En un momento me he gastado 4,83$.

Al igual que ocurre a través de ChatGPT, también puedes conectar servidores MCP remotos cuando utilizas este agente a través de la API. Pero las limitaciones son las mismas, solo puedes utilizar tools para realizar consultar y deben cumplir con las especificaciones que marca OpenAI.

🔗 Enlaces de interés

Y hasta aquí las noticias de junio, ya ves que aunque ha sido tranquilo han pasado cosas interesantes.

Espero que te haya gustado el contenido de esta cuarta edición de la newsletter, te dejo por aquí enlaces a mis redes sociales:

¡Nos vemos dentro de un mes!, ¿hablaremos de GPT-5? Puede ser.